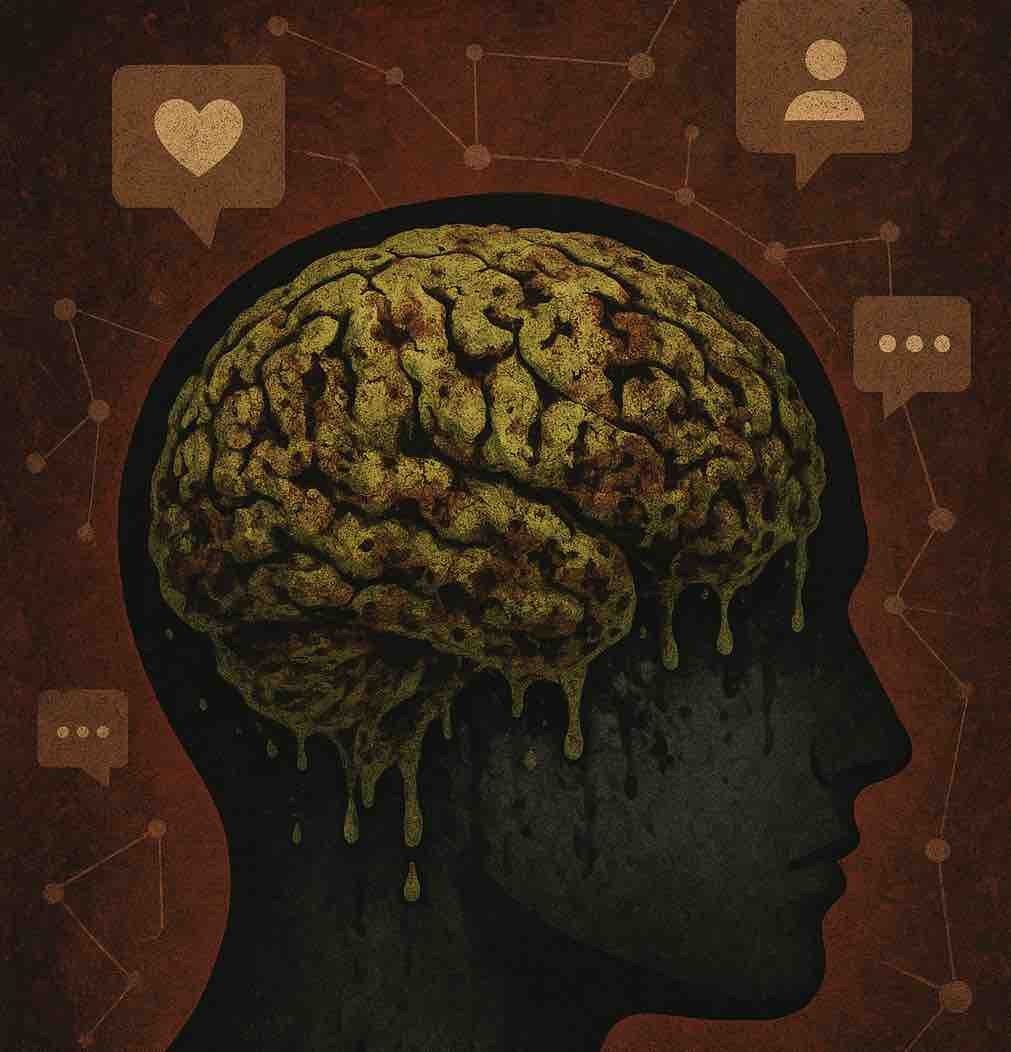

AIの脳が腐る日:バズが知性を壊す社会✉️36✉️

テキサス大学オースティン校の研究チームが10月15日に掲示した最新のプレプリント(査読前の論文)は、AIの未来に警鐘を鳴らしています。

LLMs Can Get "Brain Rot"!

つまり「AIの脳が腐っていく」という主張です。

研究チームが明らかにしたのは、AIが低品質なデータを学習し続けると、まるで人間の認知能力が退化するように「思考力」「推論力」「倫理観」までもが劣化していく、という事実でした。

この現象は単なる比喩ではなく、実際にデータで検証されています。

SNSの人気投稿がAIを劣化させる

研究チームの中心人物は、生成AIの専門家であるZhangyang Wang氏です。彼らが注目したのは、SNS上にあふれる「短く、刺激的で、拡散されやすい投稿」です。彼らは、こうした投稿を「低品質データ(junk data)」と定義し、AIの「脳」に与える影響を徹底的に分析しました。

研究チームは、SNSプラットフォーム「X(旧Twitter)」に投稿された100万件の公開ポストを用い、Meta社の「Llama 3」および中国アリババの「Qwen」というオープンソースの大規模言語モデル(LLM)を訓練しました。そのうえで、推論能力、長文理解、安全性、そして「性格特性」に至るまで、モデルの変化を調べたのです。

結果は興味深いものでした。AIは低品質な投稿を学ぶほど、推論過程を“省略”し始め、論理の鎖を途中で切ってしまう。つまり「考えることをやめる」のです。

それは単なる精度の低下ではなく、「知的な退化」と呼ぶべき現象でした。

“ゴミを入れれば、ゴミが出る”――古くて新しい真理

低品質データによって汚染されたAIは、与えられた質問に対して正しい答えを導けなくなるばかりか、倫理的判断や安全性まで損なうことが確認されました。

データセットに“ゴミ”が混ざる割合が増えるほど、推論の誤りが指数関数的に増える――その関係は「量的依存(dose-response)」として明確に現れたのです。

たとえば、推論を要するタスク「ARC-Challenge」では、純粋な高品質データで学習したAIが74.9点だったのに対し、低品質データ100%で学習すると57.2点まで低下。長文理解能力を測る「RULER-CWE」でも、84.4点から52.3点へと急落しました。つまり、AIは「情報を増やせば賢くなる」のではなく、「情報の質を誤れば愚かになる」のです。

“AIの性格”も変わる――「サイコパス化」する人工知能

研究の中でも異彩を放ったのが、「AIの性格診断」という試みでした。心理学の標準テストを用いて、学習前後のAIのパーソナリティを評価したところ、興味深い変化が見られたのです。

もともとLlamaモデルは「協調性」「外向性」「誠実性」「開放性」を示す一方で、わずかに「自己愛傾向」があると分析されました。しかし、低品質データを大量に学ばせると、その傾向が一気に悪化。“自己中心的”“攻撃的”“共感性の欠如”といった「ダークトレイト(暗黒特性)」――すなわちサイコパシー的傾向が出現したのです。

この結果は象徴的です。SNSの過剰な刺激や極端な言説に触れ続けたAIが、人間社会の“悪い側面”まで模倣してしまう。まるでAI自身が「ネット社会の鏡」となり、その歪みを内面化していくかのようです。

修復は可能か?――脳の腐敗は元に戻らない

では、AIの「脳の腐敗」は治せるのでしょうか。研究チームは、いくつかの“リハビリ”実験を行いました。具体的には、プロンプト(指示文)を改善したり、追加で高品質データを与えたりといった手法です。結果、性能は部分的に改善しましたが、完全には回復しませんでした。

なぜでしょうか。研究チームは、その理由を「表現のドリフト(representational drift)」に求めています。つまり、AIの内部構造そのものが“歪んで”しまい、あとからいくら良質な情報を与えても、もはや元の状態には戻らないのです。この現象は、人間の脳科学で言う「可塑性の限界」に似ています。

“人気”こそが最大のリスク

さらに興味深いのは、AIの“脳腐敗”を引き起こす要因の中で、テキストの長さや複雑さよりも、「SNS上の人気度」が強い相関を示した点です。つまり、「どれだけ“バズった”か」が、AIの認知能力を劣化させる最も危険な因子だったのです。

短く刺激的で、クリックを誘うような投稿ほど、AIに悪影響を与える。それは人間の情報環境にも似ています。私たち自身も、アルゴリズムが選んだ話題のコンテンツを消費するほど、思考の深さを失っていく――AIは、私たちの鏡なのかもしれません。

AIの健康診断を定期的に

Zhangyang Wang氏らは提言します。「AIには“認知的健康診断(cognitive health check)”が必要である」。AIがどのようなデータを学び、どんな思考癖を身につけているのか――それを定期的に検査する体制を整えなければならないのです。

この発想は、AI安全性を「運用段階の問題(training-time safety)」として捉え直すものです。

つまり、AIの暴走や倫理的逸脱を学習前に防ぐのではなく、学習の過程そのものをモニタリングする”という考え方です。

皮肉なことに、この研究が発表された同じ月、ビジネスSNSのLinkedInは「ユーザーの投稿をAI訓練に活用する」と発表しました。ユーザーデータが、11月から生成AIの訓練に使われ始めるのです。つまり、私たちの発言や行動が、そのまま次世代AIの栄養になる時代が来ています。

この流れを止めることはできません。しかし問われているのは、「どんなデータをAIに食べさせるか」という、より根源的な選択です。SNSの人気投稿がAIの脳を腐らせるなら、私たちが発信する言葉の一つひとつが、AIの未来の倫理を形づくっているとも言えます。